Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer

本文最后更新于:2 年前

T5

T5: Transfer Text-to-Text Transformer

C4: Colossal Clean Crawled Corpus

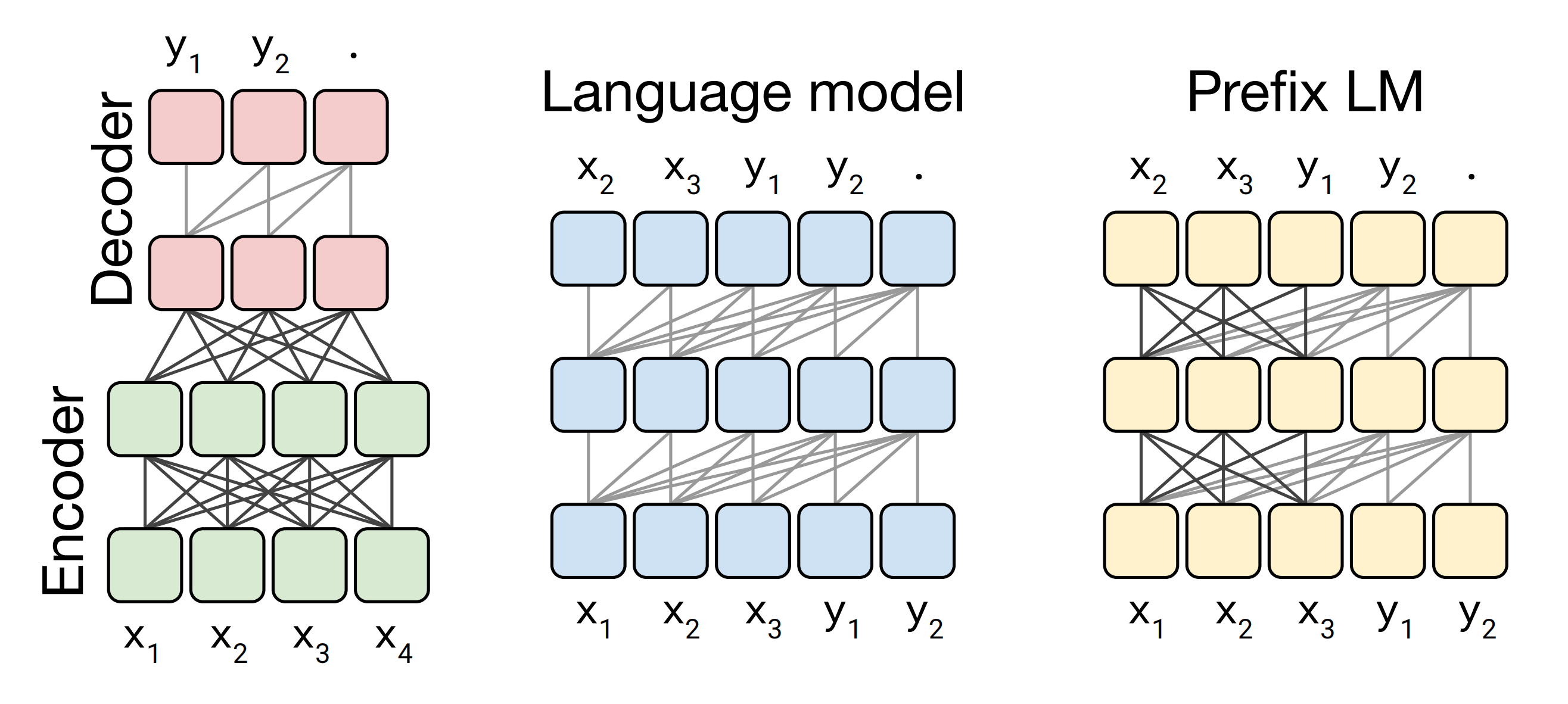

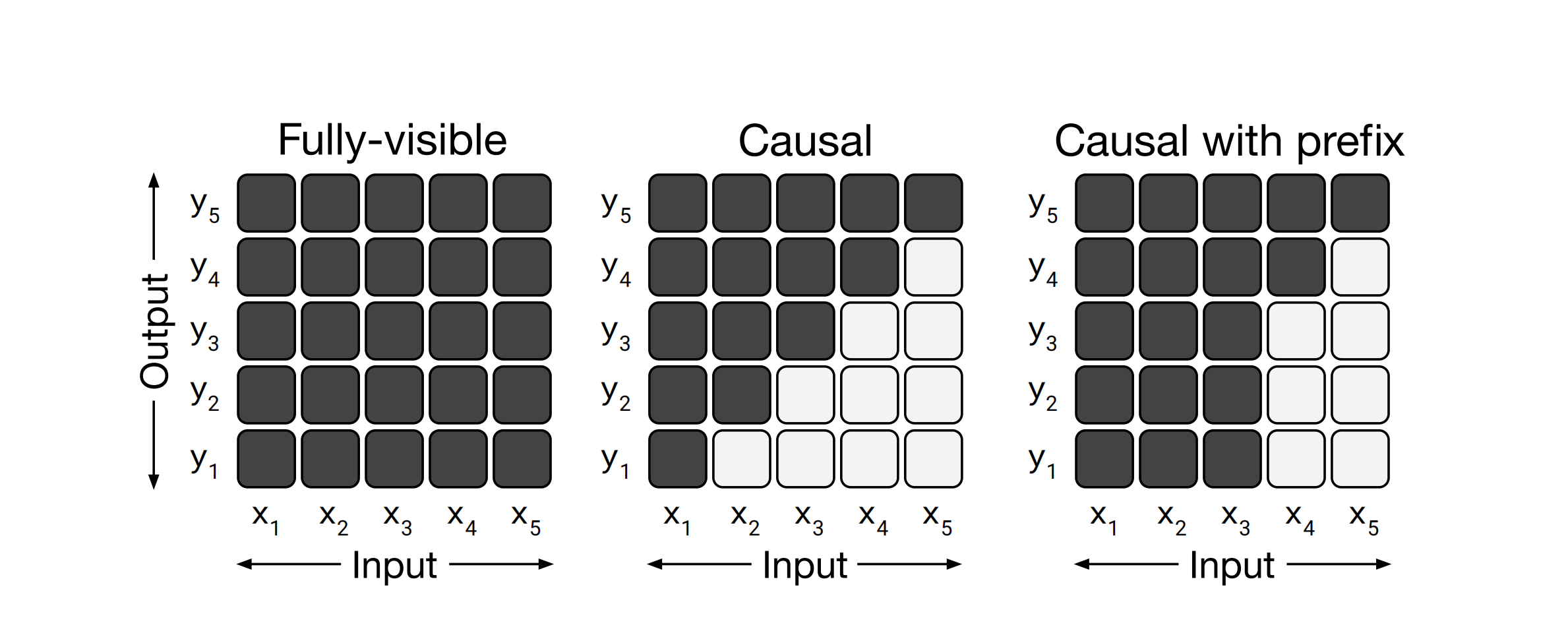

架构择优

- Encoder-Decoder(Seq2Seq,Encoder 看全体,Decoder 看之前的,效果最好)

- Decoder(看之前)

- Prefix-LM(一部分全体一部分过去)

其中两层数据之间的关联如下

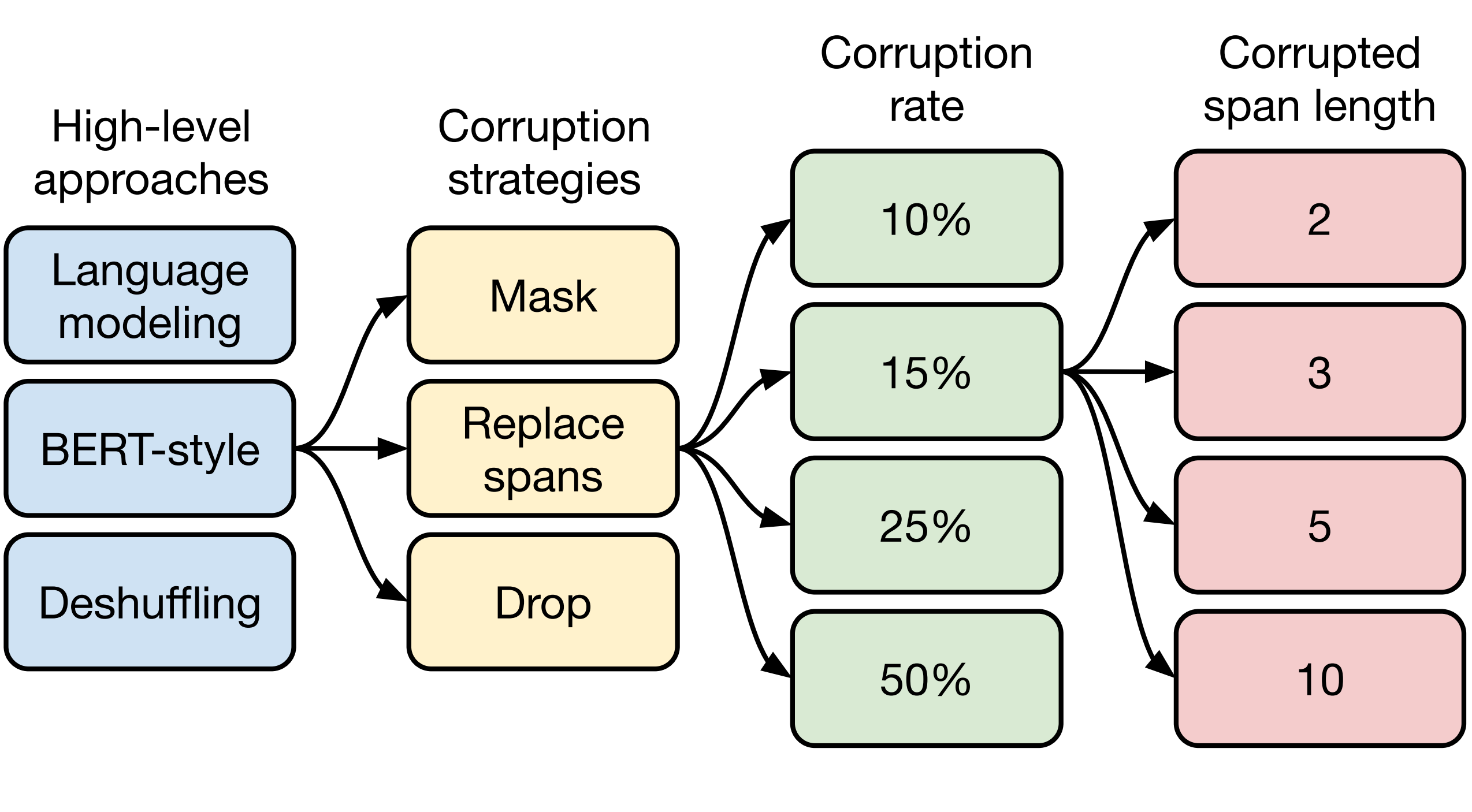

训练择优

顺次在以下并列选项中找到“最优解”,蓝色代表“胜出”

训练方式

- 语言模型式:从左到右预测

- BERT 式:还原 MASK

- Deshuffling 式:还原打乱文本

掩盖策略

- Mask:盖住 token

- Replace spans:相邻 Mask 合成一个特殊字符

- Drop:直接丢弃一些字符

掩盖比例

10%, 15%, 25%, 50% 的 MASK 比例

掩盖长度

2, 3, 5, 10 的长度

Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer

https://lr-tsinghua11.github.io/2023/02/09/NLP/T5/